현대자동차 로보틱스 채용전환형인턴 1차 면접

03 Jun 2021 | daily

3명이 들어오셨다.

직무 면접과 Peer 면접이 있었다.

면접

-

포트폴리오 발표

-

매칭포인트에 양이 많은데 어떻게 줄이는지

Ransac을 이용하여서 가치있는 매칭포인트만 고려할 수 있습니다. Epipolar line contraint으로 공간산의 좌표를 얻고 Ransac을 통해 가치있는 MapPoints들을 걸러낼 수 있습니다.

(Descriptor를 통한 매칭을 할때 이미 Ransac을 사용해서 2D Plane간에 가치있는 매칭 포인트도 구할 수 있다)

-

Epipolar Contraint으로 Essential Matrix를 얻게 되는데, 거기서 로테이션이 오류가 많은지, 트랜슬레이션이 약한지.

로테이션이 정확하고, 오히려 Translation이 부정확 합니다. 그 이유는 로테이션은 scale factor의 영향을 받지 않습니다.

-

포즈 추적 어케 했는지

이미지 시퀀스에서 얻어지는 특징점과 드스크립터를 에피폴라컨스트레인으로 통한 맵포인트드들을 생성을하고 생성된 맵포인트들을 PnP 알고리즘을 통해 이미지에 재투영하여 least squre를 통한 자세 추정을 합니다.

-

공모전 구상만 한것인지

네 그렇습니다. 가지고 있는 경험을 가지고 아이디어를 짜서 구상한 것입니다.

-

팀에서 무슨 역할을 맡았는지

저는 센서 퓨전역할을 맡아서 현지화 하는 역할을 맡았습니다. 또한 당시에 멀티지오메트리 공부를 하지 않아서, 도형이라는 특징을 이용을 하여서 공간상의 좌표를 구했었습니다.

-

알고리즘 성적 어케 생각하는지

좋지 못하였습니다. 개선해야 되는 부분이라고 생각됩니다.

-

어떤 스타일인지 팀

팀을 하나로 뭉치는 팀을 만들고 싶습니다. 한명의 낙오자도 없이, 서로 배려하며, 서로 끌고 나가며, 결국에는 다양한 아이디어를 실현할 수 있는 혁신적인 팀을 만들고 싶습니다.

-

왜 논문을 두번째로 했는지

아무래도 논문 어셉턴트를 받을 수 있는게 첫번째 보다는 두번쨰가 더 컨티리뷰션이 크다 생각하여서 그렇게 하였습니다. 아무래도 논문 어셉턴트 받는게 중요하니, 첫번째 방법보다 두번째 방법이 더 가능성이 높아 보였습니다. 그 이유는 메커님휠의 로봇 모델을 이용한 현지화이기 때문입니다.

-

석사, 학사 프로젝트 누구랑 하였는지

동료들이랑 하였습니다. 석사때에는 3명의 팀원으로 슬램을 맡은 친구, 매니퓰레이터를 맡은 친구, 저는 현지화와 객체 인식을 맡아서 했었습니다.

학사때는 친구와 둘이서 했었습니다.

-

문제가 생겼을때 어떻게 해결하였는지

보통 상대망의 의견을 경청하려고 노력 많이 하였습니다. 제가 엉뚱한 제안을 많이 하는데, 예를 들어 스마트 지팡이 만들떄도, 웅덩이도 감지하게 전선을 달자고 제안을 하였었습니다. 그러나 동료가 사실 별 의미가 없고 무의미하다고 하여서, 그런 동료의 생각을 빨리 수긍하고 프로젝트에 진행하게 되었습니다. 이것이 저의 문제 점이라 생각됩니다.

-

한국에 왜 안오는지

부모님의 경제적인 부담을 덜어주기 위해서 현재 여기에 머물고 있습니다.

-

프로젝트에 대해 설명

카메라 기반의 모바일매니퓰레이터로 책꽂이 로봇을 개발하는데 참여를 하였습니다. 카메라 기반의 슬램을 통해서 네비게이션 시스템을 만들고, 책장 주변 근처에 오게 된다면, 책을 꽂을 위치를 찾고자 책꽂이 위치에 도형을 이용하여서 책을 꽂을 공간상의 위치를 찾고자 하였습니다. 또한 카메라 기반의 현지화는 아무래도 데이터에 대한 오차가 있기 때문에, 휠센서에서 얻어지는 오도미터리와 슬램에서 얻어지는 오도미터리를 익스텐디드 칼만 필터를 통해 융합을 하면서 최적화 하였습니다.

-

개인프로젝트 그냥 오픈소스 돌린거 아닌지

아닙니다. 오픈 데이타 셋을 이용하여서, PCL의 문서를 보면서 간단하게 객체 인식을 하였습니다.

-

어려움을 겪엇던 경험들

뉴욕에서 총 맞을번한 경험

슬램을 모바일 로봇에 적용하는 알고리즘 디버그 경험

-

탐색을 어떻게 했는지

먼저 슬램에서 얻어지는 3디 맵데이터들을 얻고, 이를 octo_tree 라이버러리를 통해 ocuppied 2d map으로 변환을 시켰습니다. 이렇게 되면 이제 각셀에 occupied가 되었는지 free가 되었는지 가중치를 얻게 되는데, 이 데이터 값을 통하여 2D Image로 변환을 주었으며 Opencv 이미지 프로세싱 알고리즘을 통하여 맵에대한 형상을 구하고, centroid 알고리즘을 통하여 형상이 된 맵에 중심점을 찾게 하였습니다. 이를 현재 로봇 포즈와 고려하여서 탐색을 하도록 하였습니다.

-

네비게이션 시스템

이렇게 얻어진 맵데이터들과 탐색점을 RRT * , PRM을 사용을 하여서 자율탐색을 하고, 장애물이 발견되었을때 탐색점을 업데이트 하도록 하며, Loop Closure가 발생하였을 경우 탐색을 종료하고, 사용자가 특정 타겟포즈를 주었을때 RRT *, PRM으로 탐색할 수 있도록 하였습니다.

-

로컬리제이션

슬램에서 얻어지는 오도미터리와, 휠센서에서 얻어지는 오도미터리를 익스텐디드 칼만필터로 퓨전하여 얻도록 하였습니다.

-

카메라 말고 다른 센서 해본적 있는지

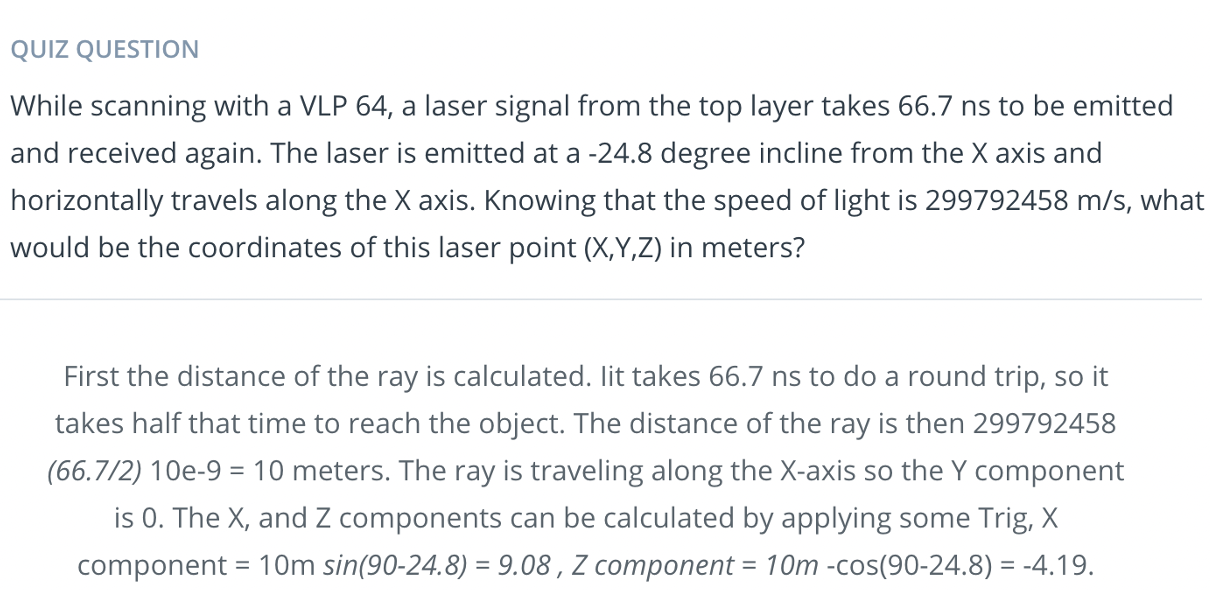

없습니다. 오픈데이터 셋으로 라이더를 이용해보았지만, 실제로 이용해본적은 없습니다.

-

로스패키지로 그냥 사용한거 아닌지

꼭 그렇지 많은 않습니다. 익스텐디드 칼만 필터 구현같은것은 제가 직접 하였습니다.

내가 했던 질문들

- 무엇을 이용하는지 로스

로스 키네틱을 사용하며 로스2로 넘어가려고 준비중

- 컴퓨터 사양

잘 모른다. 아마 지티에스가 달려있을것이다.

- 취미 생활 하시는지

운동이나 다른 것 할 시간이 많다.

3명이 들어오셨다.

직무 면접과 Peer 면접이 있었다.

면접

-

포트폴리오 발표

-

매칭포인트에 양이 많은데 어떻게 줄이는지 Ransac을 이용하여서 가치있는 매칭포인트만 고려할 수 있습니다. Epipolar line contraint으로 공간산의 좌표를 얻고 Ransac을 통해 가치있는 MapPoints들을 걸러낼 수 있습니다. (Descriptor를 통한 매칭을 할때 이미 Ransac을 사용해서 2D Plane간에 가치있는 매칭 포인트도 구할 수 있다)

-

Epipolar Contraint으로 Essential Matrix를 얻게 되는데, 거기서 로테이션이 오류가 많은지, 트랜슬레이션이 약한지. 로테이션이 정확하고, 오히려 Translation이 부정확 합니다. 그 이유는 로테이션은 scale factor의 영향을 받지 않습니다.

-

포즈 추적 어케 했는지 이미지 시퀀스에서 얻어지는 특징점과 드스크립터를 에피폴라컨스트레인으로 통한 맵포인트드들을 생성을하고 생성된 맵포인트들을 PnP 알고리즘을 통해 이미지에 재투영하여 least squre를 통한 자세 추정을 합니다.

-

공모전 구상만 한것인지 네 그렇습니다. 가지고 있는 경험을 가지고 아이디어를 짜서 구상한 것입니다.

-

팀에서 무슨 역할을 맡았는지 저는 센서 퓨전역할을 맡아서 현지화 하는 역할을 맡았습니다. 또한 당시에 멀티지오메트리 공부를 하지 않아서, 도형이라는 특징을 이용을 하여서 공간상의 좌표를 구했었습니다.

-

알고리즘 성적 어케 생각하는지 좋지 못하였습니다. 개선해야 되는 부분이라고 생각됩니다.

-

어떤 스타일인지 팀 팀을 하나로 뭉치는 팀을 만들고 싶습니다. 한명의 낙오자도 없이, 서로 배려하며, 서로 끌고 나가며, 결국에는 다양한 아이디어를 실현할 수 있는 혁신적인 팀을 만들고 싶습니다.

-

왜 논문을 두번째로 했는지 아무래도 논문 어셉턴트를 받을 수 있는게 첫번째 보다는 두번쨰가 더 컨티리뷰션이 크다 생각하여서 그렇게 하였습니다. 아무래도 논문 어셉턴트 받는게 중요하니, 첫번째 방법보다 두번째 방법이 더 가능성이 높아 보였습니다. 그 이유는 메커님휠의 로봇 모델을 이용한 현지화이기 때문입니다.

-

석사, 학사 프로젝트 누구랑 하였는지 동료들이랑 하였습니다. 석사때에는 3명의 팀원으로 슬램을 맡은 친구, 매니퓰레이터를 맡은 친구, 저는 현지화와 객체 인식을 맡아서 했었습니다. 학사때는 친구와 둘이서 했었습니다.

-

문제가 생겼을때 어떻게 해결하였는지 보통 상대망의 의견을 경청하려고 노력 많이 하였습니다. 제가 엉뚱한 제안을 많이 하는데, 예를 들어 스마트 지팡이 만들떄도, 웅덩이도 감지하게 전선을 달자고 제안을 하였었습니다. 그러나 동료가 사실 별 의미가 없고 무의미하다고 하여서, 그런 동료의 생각을 빨리 수긍하고 프로젝트에 진행하게 되었습니다. 이것이 저의 문제 점이라 생각됩니다.

-

한국에 왜 안오는지 부모님의 경제적인 부담을 덜어주기 위해서 현재 여기에 머물고 있습니다.

-

프로젝트에 대해 설명 카메라 기반의 모바일매니퓰레이터로 책꽂이 로봇을 개발하는데 참여를 하였습니다. 카메라 기반의 슬램을 통해서 네비게이션 시스템을 만들고, 책장 주변 근처에 오게 된다면, 책을 꽂을 위치를 찾고자 책꽂이 위치에 도형을 이용하여서 책을 꽂을 공간상의 위치를 찾고자 하였습니다. 또한 카메라 기반의 현지화는 아무래도 데이터에 대한 오차가 있기 때문에, 휠센서에서 얻어지는 오도미터리와 슬램에서 얻어지는 오도미터리를 익스텐디드 칼만 필터를 통해 융합을 하면서 최적화 하였습니다.

-

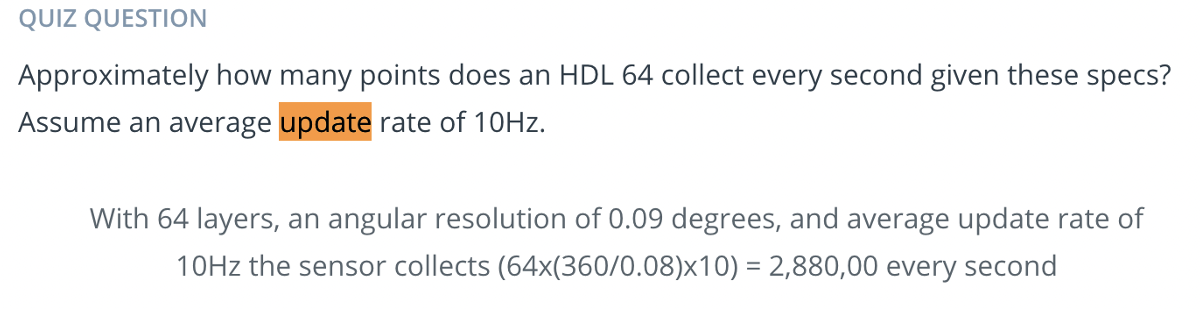

개인프로젝트 그냥 오픈소스 돌린거 아닌지 아닙니다. 오픈 데이타 셋을 이용하여서, PCL의 문서를 보면서 간단하게 객체 인식을 하였습니다.

-

어려움을 겪엇던 경험들 뉴욕에서 총 맞을번한 경험 슬램을 모바일 로봇에 적용하는 알고리즘 디버그 경험

-

탐색을 어떻게 했는지 먼저 슬램에서 얻어지는 3디 맵데이터들을 얻고, 이를 octo_tree 라이버러리를 통해 ocuppied 2d map으로 변환을 시켰습니다. 이렇게 되면 이제 각셀에 occupied가 되었는지 free가 되었는지 가중치를 얻게 되는데, 이 데이터 값을 통하여 2D Image로 변환을 주었으며 Opencv 이미지 프로세싱 알고리즘을 통하여 맵에대한 형상을 구하고, centroid 알고리즘을 통하여 형상이 된 맵에 중심점을 찾게 하였습니다. 이를 현재 로봇 포즈와 고려하여서 탐색을 하도록 하였습니다.

-

네비게이션 시스템 이렇게 얻어진 맵데이터들과 탐색점을 RRT * , PRM을 사용을 하여서 자율탐색을 하고, 장애물이 발견되었을때 탐색점을 업데이트 하도록 하며, Loop Closure가 발생하였을 경우 탐색을 종료하고, 사용자가 특정 타겟포즈를 주었을때 RRT *, PRM으로 탐색할 수 있도록 하였습니다.

-

로컬리제이션 슬램에서 얻어지는 오도미터리와, 휠센서에서 얻어지는 오도미터리를 익스텐디드 칼만필터로 퓨전하여 얻도록 하였습니다.

-

카메라 말고 다른 센서 해본적 있는지 없습니다. 오픈데이터 셋으로 라이더를 이용해보았지만, 실제로 이용해본적은 없습니다.

-

로스패키지로 그냥 사용한거 아닌지 꼭 그렇지 많은 않습니다. 익스텐디드 칼만 필터 구현같은것은 제가 직접 하였습니다.

내가 했던 질문들

- 무엇을 이용하는지 로스 로스 키네틱을 사용하며 로스2로 넘어가려고 준비중

- 컴퓨터 사양 잘 모른다. 아마 지티에스가 달려있을것이다.

- 취미 생활 하시는지 운동이나 다른 것 할 시간이 많다.